A/B-testen is slecht voor je conversie [infographic]

Testen en optimaliseren – deze twee activiteiten zijn doorgaans onlosmakelijk met elkaar verbonden. En altijd in dezelfde volgorde: eerst testen, dan optimaliseren. Maar waarom? Als we onze website continu willen verbeteren, waarom wachten we daar nog altijd mee tot het einde van de testfase? En waarom richten we onze tests altijd op ‘de gemiddelde bezoeker’? Op deze manier lopen we heel wat conversie mis!

We zijn het er allemaal wel over eens dat het goed is om te testen en optimaliseren. Het levert je namelijk allerlei voordelen op.

- De online ervaring van je bezoekers wordt steeds gebruiksvriendelijker en relevanter, omdat je je website steeds beter afstemt op hun behoeftes.

- Doordat je weet op welke banner, knop, formulier, enzovoort bezoekers het meest doorklikken, kun je je conversieratio verhogen en meer inkomsten genereren.

- En niet onbelangrijk: dankzij testresultaten kun je je standpunt – bijvoorbeeld tijdens een afdelingsoverleg – staven met harde cijfers.

Er zijn testmethodes genoeg…

Niet alleen de voordelen zijn talrijk, maar ook de variatie in testmethodes is erg groot. Marketeers kunnen kiezen voor kwalitatieve technieken, zoals een expert review of online klantenquête, maar kunnen ook gaan voor een kwantitatieve methode, zoals A/B-testen, multivariate testen en heatmaps.

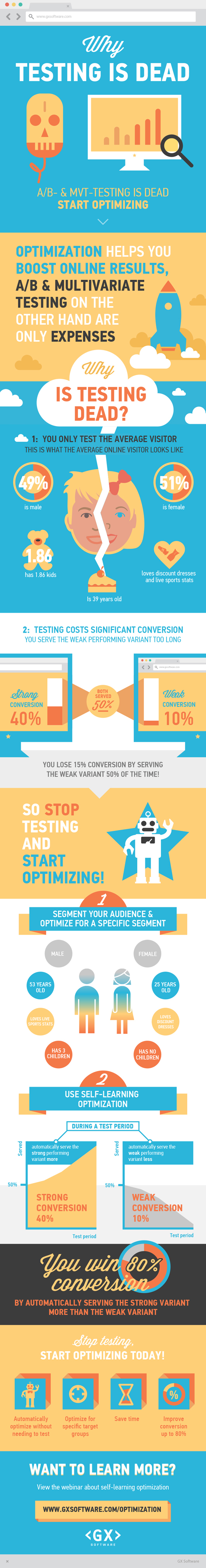

… maar ze hebben allemaal twee grote nadelen

Hoe gevarieerd en zinvol deze traditionele technieken ook zijn, ze kennen twee belangrijke beperkingen. Ten eerste wordt er vaak getest op ‘de gemiddelde bezoeker’. Deze gemiddelde bezoeker is een optelsom van allerlei doelgroepen bij elkaar en is daardoor juist níet representatief voor jouw specifieke doelgroep. Ten tweede wordt de website pas geoptimaliseerd ná afronding van de testfase; hiermee loop je veel conversie mis.

Je zet bijvoorbeeld een A/B-test uit om te achterhalen welke banner het beste werkt. Je toont alle bezoekers een maand lang twee varianten. Na afloop stel je vast welke banner het beste heeft geconverteerd voor de gemiddelde bezoeker (je maakt immers geen onderscheid in doelgroepen bij je test). Vanaf dat moment stop je met het tonen van de minder converterende banner. Maar dat betekent wèl dat je een hele maand lang de minder converterende variant aan maar liefst de hélft van al je bezoekers hebt laten zien.

Dit kan slimmer!

Kies daarom voor zelflerende optimalisatie

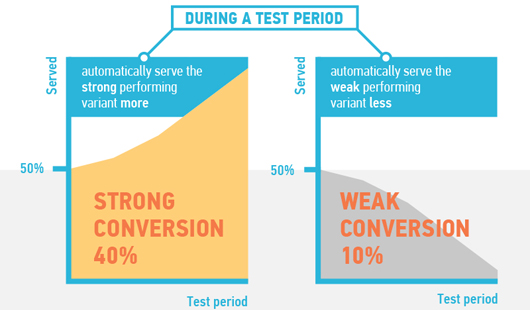

Gelukkig is voor dit probleem een oplossing bedacht: zelflerende optimalisatie. Deze techniek draait op het multi-armed-bandit-algoritme. Ik zal even kort uitleggen hoe dit werkt. Net als bij de A/B-test in het voorbeeld hierboven, begin je evengoed met het gelijkwaardig uitserveren van twee banners. Maar al snel laat je de (tot dan toe) beter werkende versie steeds vaker en vaker zien. Je bent dan dus al aan het optimaliseren, terwijl je óók nog aan het testen bent. Daarnaast is het aan te raden om in plaats van alle online bezoekers tegelijk te testen, je te richten op een specifieke doelgroep. Je wilt immers niet weten welke voorkeur een gemiddelde bezoeker heeft, maar welke voorkeur jouw doelgroep heeft.

De resultaten spreken voor zich: het conversiepercentage loopt door het eerder uitserveren van de juiste variant aan de juiste doelgroep behoorlijk op – tot maar liefst 80 procent.

Kritiek en weerstand

Deze techniek is niet overal even positief ontvangen. Critici merken op dat de zuiverheid van de resultaten wordt benadeeld door al vroegtijdig de beter werkende versie ‘voor te trekken’. Volgens hen loop je dus het risico dat je te snel stopt met zuiver testen, waardoor je niet met statistische significantie zou kunnen aantonen dat de ene banner beter werkt dan de andere. Evan Miller geeft hierop zijn visie in deze blog, waarvoor enige kennis van statistiek wel handig is.

Ik geef deze critici zeker geen ongelijk. Maar wat telt, is dit: een marketeer wordt aan het einde van de rit niet afgerekend op het meest waterdichte bewijs, maar op zo veel mogelijk opbrengsten. Juist om die reden is de techniek van zelflerende optimalisatie ook ontwikkeld. Zonder onjuiste conclusies te trekken of regelrecht tegen significantie in te gaan, garandeert deze methode het minste verlies tijdens het testen. Het algoritme streeft dus even goed naar significantie, alleen duurt het aantonen daarvan iets langer. Zelf merk ik bovendien dat zuivere significantie een stuk minder belangrijk is, als je aantoont dat je met deze methode onder de streep meer geld in het laatje brengt.

Zo is het maar net

Ik ben dan ook zeker niet de enige voorstander van zelflerende optimalisatie voor het verhogen van conversieratio’s. Sterker nog, juist een van de critici onderstreept mijn standpunt. Paras Chopra concludeert in zijn blog:

“A/B testing is meant for strict experiments where focus is on statistical significance, whereas multi-armed bandit algorithms are meant for continuous optimization where focus is on maintaining higher average conversion rate.”

Point taken!

4 Reacties

Plaats reactie

Je moet ingelogd zijn op om een reactie te plaatsen.

Guus, goed stuk en erg mooie info graphic.

Zelf passen we ook zelflerende optimalisatie toe bij AB testen en veel software voor AB testen biedt gelukkig ook de mogelijkheid om zelflerende optimalisatie toe te passen.

Van groot belang ook omdat soms een variant zelfs echt conversieverlagend kan werken..