100% (not provided) komt eraan – wat nu?

Het kriebelde al een tijdje, maar nu is de knoop dan definitief doorgehakt: (not provided) gaat de komende weken / maanden naar 100%. Dat wil zeggen dat wij geen keyword-data mee krijgen van organische zoekopdrachten vanuit Google: je ziet als website-eigenaar dus niet meer op basis van welke zoektermen bezoekers op je site terechtkomen. Alle zoekopdrachten gaan in de hele nabije toekomst via https, oftewel een beveiligde verbinding, waardoor vanuit privacy-overweging de data bij Google achterblijven. Privacy blijft hierin het toverwoord. Want dat is de reden waarom Google dit doet. De veiligheid van de gebruiker! … Echt waar?

Nu is het klaar!

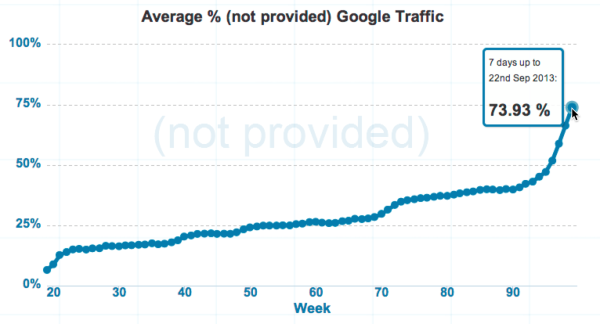

Het voelt allemaal heel plotseling. Het is niet zo dat we het niet zagen aankomen. Al vanaf 2011 werd delen van de keyword referal data afgeschermd van zoekers die gebruikmaken van een beveiligde verbinding; zoekers die bijvoorbeeld ingelogd zijn met een Google Account en vervolgens gaan zoeken. Daardoor zagen we in statistieken een gestaagde groei van het aandeel (not provided), waarbij de laatste cijfers rond de 40% zaten.

Vanaf september 2013 was de echte verandering merkbaar. Via de website notprovidedcount.com was te zien hoe snel het aandeel van (not provided) groeide in één maand tijd. Naar bijna 70%? Het was een duidelijk signaal. Keyword-data vanuit organische bezoekers worden niet langer meegegeven. Per direct? Nee, maar wel snel. Waarschijnlijk zullen we het de komende maanden zien gebeuren.

Google’s ‘double standard’

Maar laten we het ook van een andere kant bekijken: deze data zijn een soort stilzwijgend vennootschap tussen zoekmachines en website-eigenaren. Zoekmachines mochten onze website crawlen en deze data gebruiken, wij kregen de data op keywordniveau terug. Mooi verbond en waardevolle data voor beide. En nee, marketeers deden geen slechte dingen met deze data. Ze worden gebruikt om ervoor te zorgen dat websites beter worden en dat er meer waardevolle informatie te vinden is. Dus keyword-data, jullie zullen gemist worden!

En breek me de bek al helemaal niet open over Google’s dubbele standaard. Privacy of niet, zolang je aan je betalende klanten deze data nog wel gewoon mee geeft, klopt er iets niet in je beweegredenen om dit te doen. Waarom zou je de data wel via SEA meegeven en niet via SEO? Zelfde zoeker, zelfde zoekmachine, zelfde intentie. Puur een actie om meer gebruikers naar AdWords te krijgen? Want daar zijn die heerlijke keyword-data nog gewoon beschikbaar.

Maar genoeg daarover. Het is een feit dat dit de komende tijd uitgerold gaat worden. Wij zijn deze data kwijt. Ja, niet alleen SEO’ers, maar ook jij als website-eigenaar hebt straks geen inzicht meer in deze data. Het geldt voor iedereen! Dus geen SEO-wijziging van Ome Google, maar een aanpassing in data voor iedere website-eigenaar. Dus wij zijn allemaal deze data kwijt. Misschien voorlopig, misschien voor altijd, maar voor nu kunnen we het niet meer gebruiken.

Tinfoil hat-moment

Heb je nog een stukje aluminiumfolie klaar liggen? Mooi, vouw er een hoedje van en lees verder. Een interessante kijk op dit verhaal komt van Will Critchlow. Hij legt in deze video goed uit waar search de komende tijd naar toe gaat. Nu al worden veel van onze zoekresultaten aangepast aan onze locatie, het apparaat waar we mee zoeken, onze persoonlijke voorkeuren, het IP-adres, noem maar op. Twee zoekopdrachten zijn dan ook nooit hetzelfde. Als je een paar jaar geleden zocht op “restaurant” in Google, kreeg je algemene pagina’s over het woord restaurant en misschien een verdwaald resultaat van een restaurant in de buurt. Zinloze zoekterm en als lokaal restaurant zinloos om je daar op te gaan richten.

Tegenwoordig kan “restaurant” op je smartphone een prima zoekterm zijn. Google weet dat je bijvoorbeeld in Groningen loopt en dat The Sushi Mall het dichtstbijzijnde restaurant is. Deze rankt, puur op basis van je persoonlijke eigenschappen. Wil je dan in je analytics-data zien dat je rankt op “restaurant”? Ja je rankt er op, maar alleen voor één persoon en ook nog omdat hij of zij op basis van allemaal omgevingsfactoren dit heeft bewerkstelligd. Vertekende data, die je niet wilt zien.

En deze manier van zoeken wordt steeds meer onze way of search. Wij gaan er steeds meer van uit dat Google ons zoekprobleem wel voor ons oplost. Minder data invoeren, minder precies, want Google zorgt voor de impliciete data. Goede reden om gefaseerd (en nu het laatste stukje) keyword-data niet meer mee te geven. Take that as a conspiracy theory!

Echte oplossingen?

Zijn er echte oplossingen voor dit probleem? Niet echt. Uiteraard zijn er alternatieven. We hebben bijvoorbeeld onze data vanuit Google Webmaster Tools. Echter, deze data zijn vaak niet compleet en/of lopen een paar dagen achter. Nog een nadeel is dat we maar 90 dagen terug kunnen kijken, alhoewel Google ons heeft beloofd dat dat binnenkort gaat veranderen naar 1 jaar; een doekje voor het bloeden.

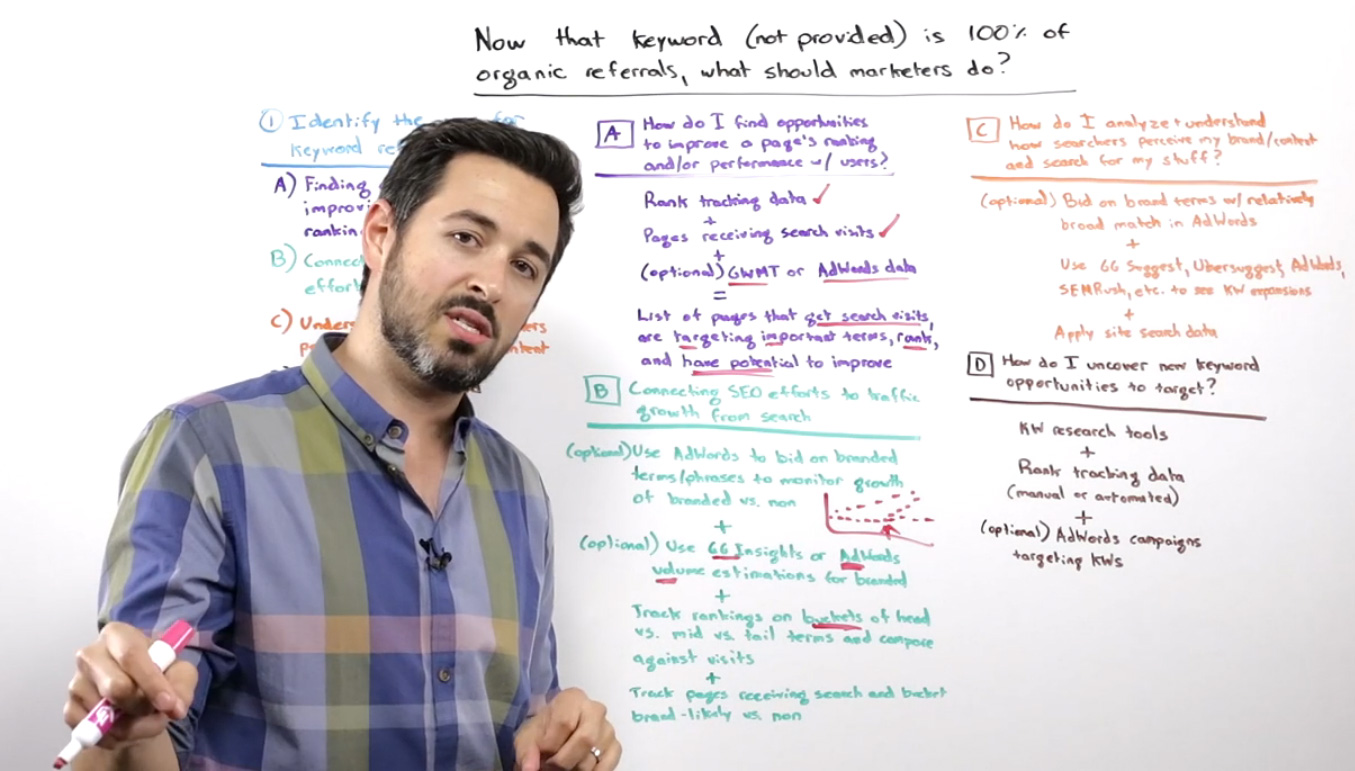

Maar als we heel eerlijk zijn, is er geen goede directe oplossing. We zijn deze data kwijt en we moeten naar een andere manier van rapporteren. Denk bijvoorbeeld aan het rapporteren van de pagina’s binnen de website die het goed doen in SEO (waar dus veel verkeer op binnenkomt). Meer informatie over wat we met de data deden en eventuele oplossingen zie je in een video van Rand Fishkin.

Accepteren!

Als er een conclusie is na alles wat hier over gezegd is en de komende dagen over geschreven gaat worden: keyword-data vanuit SEO zijn we kwijt. Dat is iets wat wij allemaal moeten accepteren. Is het zuur? Jazeker! De Dijk zong ooit: “Een man weet pas wat ie mist, als ze er niet is“. Als we het straks niet meer hebben, weten we pas echt wat we er aan hadden. Aan de andere kant is het ook zo dat wij met SEO heel veel andere data voorhanden hebben die geen enkel ander online kanaal heeft. Door alle tools die voorhanden zijn, hebben we een bak aan data waar we mee aan de slag kunnen.

Dus de komende dagen gaan we collectief een paar Google-posters doormidden scheuren, gratis 75 euro AdWords-tegoedvouchers verbranden, een dikke traan laten biggelen en dan door. Want SEO is niet anders geworden. Websites beter maken kan nog steeds! Met of zonder keyword-data.

Credits afbeelding: Lorenzo Sernicola (CC)

Leuk artikel Siegfried! We zaten er natuurlijk op te wachten. Google was al geruime tijd aan het afbouwen. Ik zag zelf al 80% niet meer van mijn websites.

Het zou mij niks verbazen als Google deze data voor de toekomst nog eens gaat verkopen. In een vorm van Google Analytics Pro!? De toekomst zal het uitwijzen….

Leuk stuk Siegfried en helemaal eens met je eindconclusie!

Heldere uitleg van Will Critchlow ook.

Goed artikel, vervelend nieuws. Maar goed, het forceert ‘ons’, het internetvolk, wel om kwalitatief goede content te creëren en niet alleen meer te kijken naar keywords.

dus eigenlijk goed nieuws (vooral voor ‘onze’ bezoekers) Ines?

Ik meen van wel, Richard. Als je niet anders kunt dan goede content leveren is dat voordelig voor zowel bezoekers als websitehouders. Ik zie de voordelen wel!

Er is nog een interessante oplossing, waar blijkbaar niemand over spreekt. Dankzij de nieuwe koppeling tussen de webmaster tools en AdWords wordt ook veel organische informatie zichtbaar (via de nieuwe dimensie).

Door op een zoekwoord te adverteren is dan ook zichtbaar hoe vaak je er organisch op bent vertoond, de positie en het aantal klikken. Het is niet zoals Analytics, maar het is nauwkeuriger dan enkel de webmaster tools.

Hi Siegfried,

Superartikel. Ik ga het zeker delen binnen mijn kring. Ik ben benieuwd wat straks de ontwikkelingen zijn om deze data (en de bruikbaarheid hiervan) goed in kaart te brengen. Nu heeft iedereen natuurlijk zijn eigen manier van rapporteren, maar wellicht dat er door deze ontwikkelingen verbeterde tools op de markt komen.

Top!

Via Google Webmasters kan je dus nog wel de instapzoekwoorden downloaden gelukkig.

Goed artikel, jammer dat het geen antwoord bied op de hoofdvraag in de titel 😉

@Rams: je bedoelt een antwoord op die “wat nu”? Die geeft Siegfried wel hoor, want volgens hem moeten we allemaal Google-posters verscheuren, tegoedvouchers verbranden, even slikken en weer doorgaan. Want eigenlijk verandert er niet zo veel. Zijn woorden, he, niet de mijne… 🙂

@Remi van Beekum

In dat artikel wordt beschreven dat de nieuwe dimensie geen toegevoegde waarde heeft voor SEO, omdat het niet accuraat is. In de praktijk blijkt deze data vaak accurater dan de meeste gegevens in de webmaster tools, met name op long tail. AdWords moet goed zijn ingericht, maar dan geeft het zeker wel duidelijke(re) inzichten. Zeker nu met het ‘not provided’ verhaal. Vandaar dat ik het gek vond dat dit niet als suggestie wordt gegeven.

Het is grappig dat we het eenvoudige en voor de hand liggende vaak niet direct opmerken.

Ik vind jouw suggestie omtrent de koppeling tussen de Google Webmaster Tools en Google AdWords alvast zéér sterk en uiterst bruikbaar. Bedankt hiervoor, Maarten!

Comment:

(not provided)

😛

Ze kunnen het grijgen zoals ze het willen.

Google robots kunnen wij zelf blokkeren toch!

Surfen met Bing kan ook, en met goede resultaten ^^

Ik hoop dat Bing ook iets gaat doen met Ads

Ben nu van 20 euro per dag gezakt naar 1,5 euro

en voor HTTPS domeinen moet je ook extra betalen, dus Google zal het zelf wel merken als ze hier door steeds slechter door bezoekers worden gewaardeerd ^^

Gerelateerde artikelen

Marketingfacts. Elke dag vers. Mis niks!

Marketingfacts. Elke dag vers. Mis niks!